大模型预训练是什么 如何理解?

如果我们接触AIGC,经常会听到”大模型训练“这个词,为什么要训练,训练什么?我们比较模糊或者似懂非懂,本文就大模型训练作一个介绍。

简单地说,大模型预训练是指利用大规模语料库进行模型训练,以提高模型的泛化能力和表现。

一、大模型预训练的基本概念

大模型预训练是指在大量语料库上,技术人员进行模型训练的过程。这些语料库通常包含海量的文本数据,涵盖了各种领域和语言。通过在大规模语料库上训练模型,可以使得模型具备更强的泛化能力和表现力。

具体而言,大模型预训练采用深度学习技术,将海量文本数据输入到模型中,通过无监督学习的方式让模型自主地学习到语言的规则、模式和语义信息。

预训练模型发展史

二、大模型预训练的方法

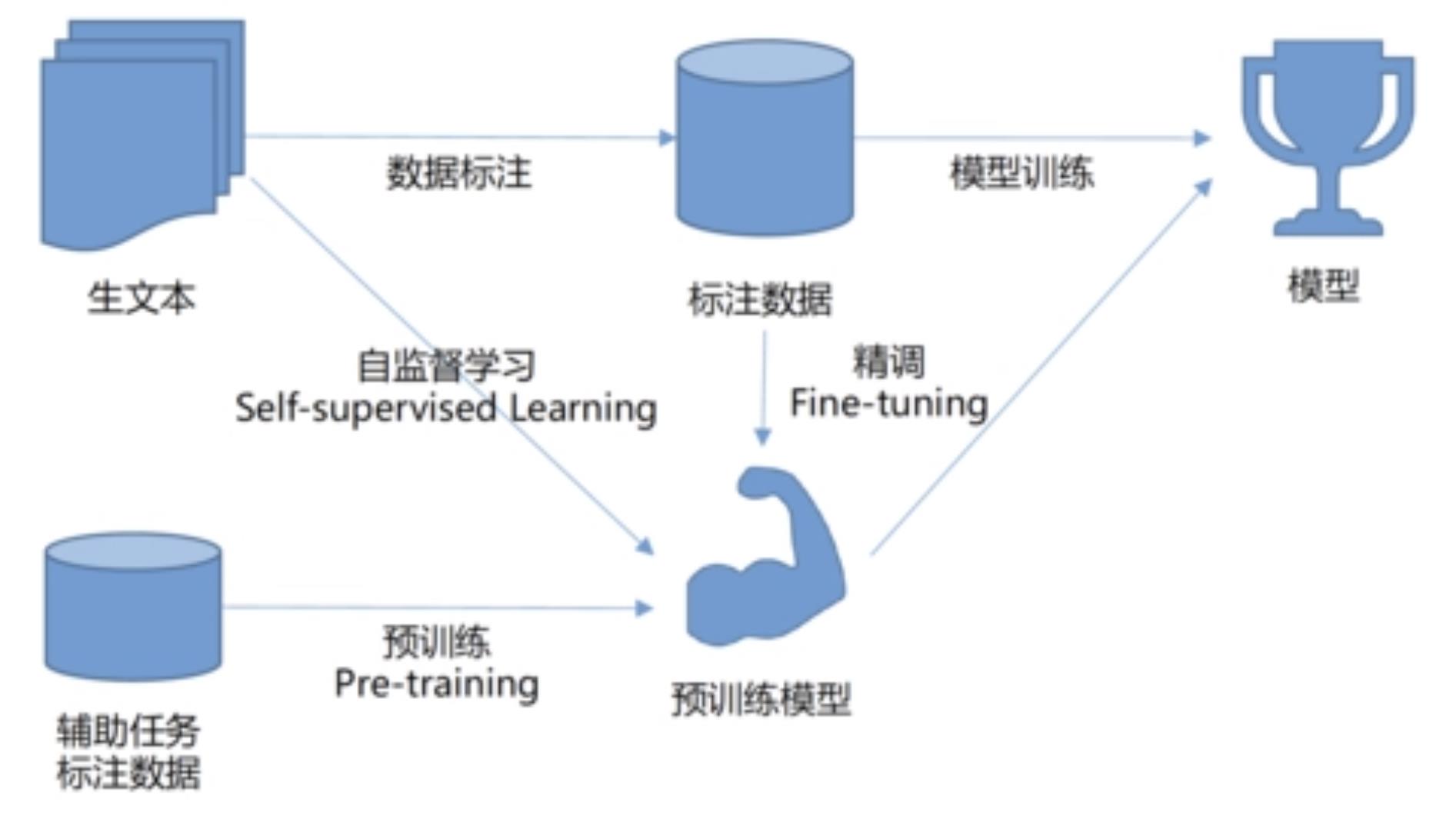

大模型预训练的方法主要有两种:自监督学习和半监督学习。

1. 自监督学习

自监督学习是指利用大规模无标签的语料库进行模型训练。通过让模型对输入的文本数据进行预测或生成,从而学习到语言的内在规律和结构。比如,语言模型中的语言生成任务就是一种自监督学习任务,让模型预测下一个词或下一个句子。

2. 半监督学习

半监督学习是指利用部分有标签的语料库进行模型训练。这种方法可以结合大规模无标签语料库和有标签语料库的优势,提高模型的泛化能力。在实际应用中,如在机器翻译任务中,可以利用部分已翻译的语料库进行模型训练,让模型学习到翻译的内在规律和结构,从而实现对未翻译句子的准确翻译。

三、大模型预训练的实际应用

大模型预训练在自然语言处理领域得到了广泛应用,以下是几个实例:

1. 文本分类

大模型预训练可以应用于文本分类任务中。通过训练一个大规模的语言模型,将文本表示为一个向量,然后利用分类器对文本进行分类。这种方法可以有效地提高文本分类的准确率和效率。

2. 机器翻译

大模型预训练在机器翻译任务中展现出了惊人的效果。通过训练一个大规模的翻译模型,可以将源语言文本自动翻译成目标语言文本。这种翻译方法不仅提高了翻译的准确度,还降低了翻译成本。

3. 语音识别

大模型预训练也可以应用于语音识别任务中。我们通过训练一个大规模的语言模型,将语音信号转化为文本形式。这种方法可以提高语音识别的准确率和鲁棒性。

4. 自然语言生成

最后,大模型预训练还可以应用于自然语言生成任务中。通过训练一个大规模的生成模型,可以生成高质量的目标语言文本。这种方法可以广泛应用于文本生成、对话生成等领域。

目前,大模型训练是AI领域中一个重要的子领域,也是发展最为迅速的一个领域,我们要准备着这个领域带给我们更多的惊喜!

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/822.html