揭开神神秘秘的神经网络算法的“面纱”

一、神经网络算法是什么

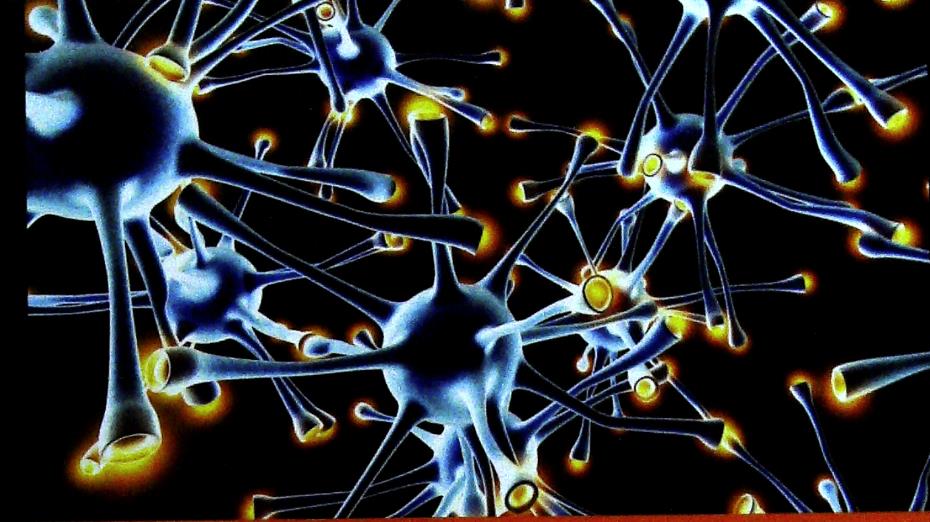

人类神经系统由亿万个神经元组成,这些神经元通过复杂的连接和信号传递来处理信息。为了模拟这种行为,神经网络算法通过模拟神经元的连接和信号处理方式来构建一个可以处理信息的模型。

神经网络的基本结构由输入层、隐藏层和输出层组成。每个神经元都有一个权重,这个权重决定了它对其他神经元的输入影响力。在处理信息时,神经网络通过对输入信息进行加权求和,然后将这个值传递给激活函数,如sigmoid、ReLU等,激活函数将这个值转化为一个可以处理的输出。

除了最基本的的前馈神经网络,还有卷积神经网络(CNN)、循环神经网络(RNN)、长短时记忆网络(LSTM)等更复杂的神经网络结构。这些结构可以更好地模拟人类神经系统的复杂工作方式,并处理更复杂的问题。例如,CNN适合处理图像数据,RNN适合处理序列数据等。

二、神经网络算法的训练

神经网络算法通过训练来学习。训练过程包括两个主要步骤:前向传播和反向传播。

前向传播是将输入信息通过网络传递到输出端,得到一个预测结果。这个过程中,每个神经元接收来自其他神经元的输入,将其与自己的权重相乘,然后将这个值传递给激活函数。激活函数将这个值转化为一个输出,并将其传递给下一层神经元。最终,输出层的神经元将所有输入整合起来,形成一个最终的预测结果。

而反向传播是根据预测结果与实际结果的误差,调整网络中的权重,使预测结果更接近实际结果。在反向传播过程中,首先计算输出层神经元与实际结果的误差,然后将这个误差反向传递给网络中的每个神经元。每个神经元根据这个误差调整自己的权重,以便在下一次前向传播时得到更准确的预测结果。这个过程一直重复,直到网络收敛,即预测结果与实际结果足够接近。

在训练神经网络时,还需要考虑如何选择合适的损失函数、激活函数、优化器和超参数等问题。损失函数用于衡量预测结果与实际结果的误差;激活函数用于将神经元的输入转化为输出;优化器用于控制训练过程中权重的更新方式;超参数则是一些需要手动设置的参数,例如学习率、迭代次数等。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/598.html