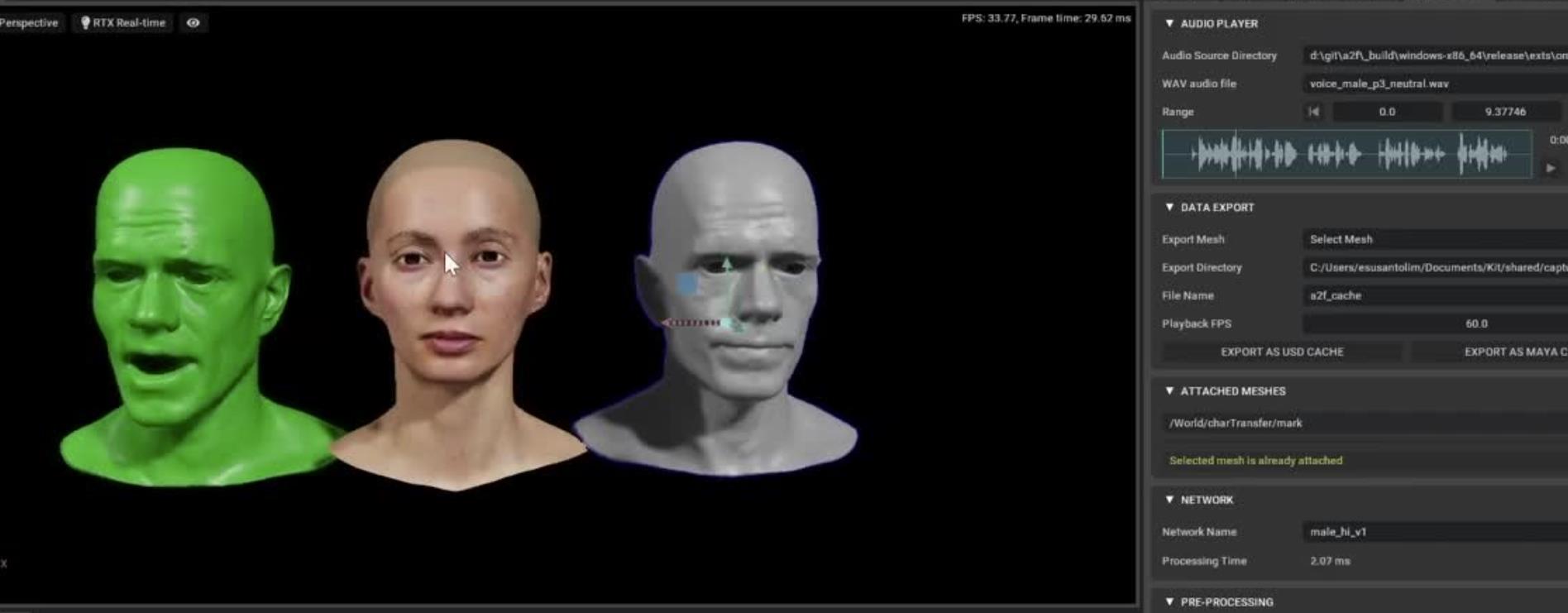

AI系统控制虚拟数字人的面部表情

AI系统控制虚拟数字人的面部表情,主要是通过深度学习和计算机视觉技术实现的。

首先,AI系统需要收集大量的面部表情数据。这些数据可以来自于真实的人类演员,也可以来自于动画或游戏角色。这些数据会被用来训练AI模型,使其能够理解和识别不同的面部表情。

然后,AI系统会使用深度学习算法来训练一个面部表情识别模型。模型会学习如何从输入的图像或视频中提取出面部特征,并识别出对应的面部表情。这个过程通常涉及到卷积神经网络(CNN)和循环神经网络(RNN)等复杂的深度学习模型。

接下来,AI系统会使用这个面部表情识别模型,以来实时分析虚拟数字人的面部表情。这通常需要使用到计算机视觉技术,如面部检测、特征提取和表情识别等。

最后,AI系统会根据分析结果来控制虚拟数字人的面部表情。举例来讲,如果AI系统检测到虚拟数字人的面部表情是开心的,那么它可能会让虚拟数字人的眼睛放大、嘴角上扬,以增强这种开心的表情。反之,如果AI系统检测到虚拟数字人的面部表情是悲伤的,那么它可能会让虚拟数字人的眼睛变小、嘴角下弯,以增强这种悲伤的表情。

此外,AI系统还可以根据用户的输入或环境的变化,来动态调整虚拟数字人的面部表情。举个例子,如果用户说了一个笑话,AI系统可能会让虚拟数字人露出笑容;如果环境变得紧张,AI系统可能会让虚拟数字人露出紧张的表情。

综合来讲,AI系统控制虚拟数字人的面部表情是一个涉及到深度学习、计算机视觉和人工智能等多个领域的复杂过程。但是,随着这些技术的不断发展和完善,我们可以期待在未来看到更加真实、生动的虚拟数字人。

然而,这个过程也存在一些挑战。例如,面部表情是非常复杂的,它们不仅受到肌肉运动的影响,还受到情绪、心理状态等多种因素的影响。因此,要准确地识别和模拟面部表情,需要大量的数据和高级的算法。此外,由于每个人的面部表情都是独一无二的,因此需要对每个虚拟数字人进行个性化的训练和调整。

随着技术的发展,我们有理由相信,AI系统将能够更好地控制虚拟数字人的面部表情,从而提供更加丰富、个性化的用户体验!

小编推荐:

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1157.html