AI语音如何驱动虚拟数字人微表情?

AI语音驱动又称为虚拟形象语音动画合成技术(Voice-to-Animation),用户通过输入文本或语音,以一定规则或深度学习算法,生成对应的3D虚拟形象的人脸表情系数,完成口型和面部表情的精准驱动。

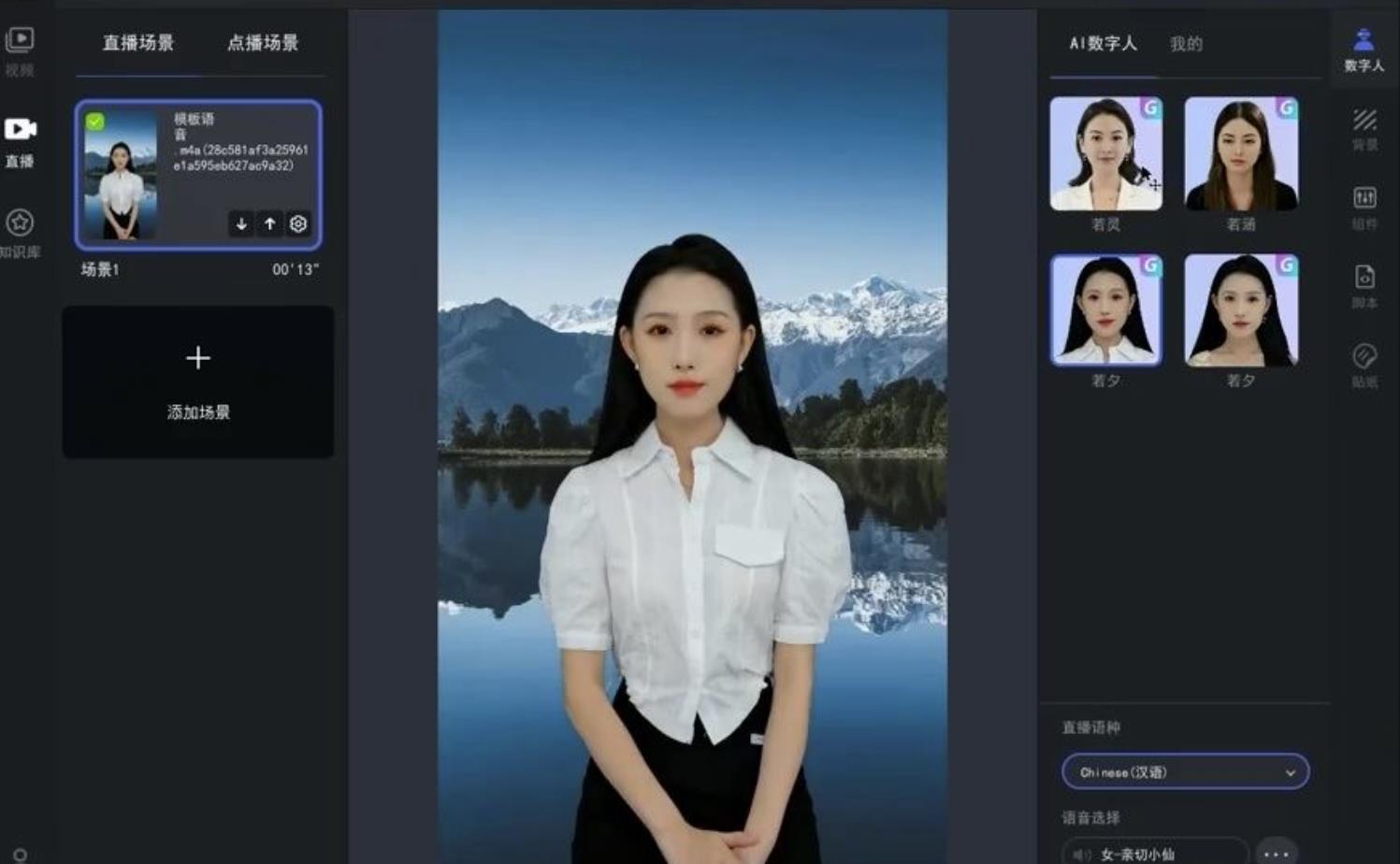

通过AI语音驱动技术,开发者可以快速构建丰富的虚拟形象智能驱动应用,如虚拟主持人、虚拟客服、虚拟教师等。

AI数字人生成

根据输入内容的不同(文本/语音),可以分为三种驱动方法:

1、语音驱动

将语音作为输入源,通过深度模型预测嘴型和面部微表情。这种方法的优点是不受限于不同人、不同国家,但是受到语音特性(音色、强度、噪声等)影响较大,较难提升模型的泛化能力。

2、音素驱动

将文本时间序列转换成音素时间序列,并将其输入到深度模型中,以预测嘴型和面部微表情。这种方法的优点是与语音无关,只与文本内容相关,不受语音特性变换影响。但是,这种模型受限于不同国家的文本语言(中英等)。

3、语音和音素多模融合驱动

融合语音和文本两个模态的信息,驱动系数更准确,效果更好,但模型更复杂。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/510.html