了解AI大模型训练的超参数意义

AI大模型中的超参数是指在模型训练过程中需要预先设定的参数。这些参数不能通过训练过程本身学习得到,而是需要通过实验和经验来调整优化的参数。

超参数对模型的表现和性能具有重要影响,因此在大模型训练过程中,选择合适的超参数是非常关键的。

超参数的主要作用包括控制模型训练过程、影响模型学习能力和模型泛化能力等。

下面我们将举例说明几个常见的超参数及其影响:

学习率(Learning Rate)

学习率是控制模型训练速度的参数,它决定了模型在每次更新权重时所采用的步长。如果学习率设置过高,可能会导致模型在训练过程中震荡或偏离最优解;如果学习率设置过低,则会导致模型训练速度较慢,需要更多的训练轮次。

批次大小(Batch Size)

批次大小是每次更新权重时所使用的样本数量。批次大小的选择会影响模型的收敛速度和训练稳定性。如果批次大小设置过大,会导致训练过程不稳定;如果批次大小设置过小,则会导致训练过程较慢。

激活函数(Activation Function)

激活函数是用于非线性变换的函数,如ReLU、sigmoid和tanh等。激活函数的选择会影响模型的非线性能力和表达能力。不同的激活函数具有不同的特性,如ReLU具有简单性和稀疏性,sigmoid具有饱和性和梯度消失问题,tanh具有对称性和较大的输出范围。

优化器(Optimizer)

优化器是用于优化模型权重的算法。常见的优化器包括SGD、Adam和RMSProp等。不同的优化器具有不同的特点和适用场景。例如,SGD具有简单性和快速收敛速度,但容易震荡;Adam具有自适应学习率和均一梯度衰减,适用于大多数场景;RMSProp具有自适应学习率和记忆衰减,适用于深度学习场景。

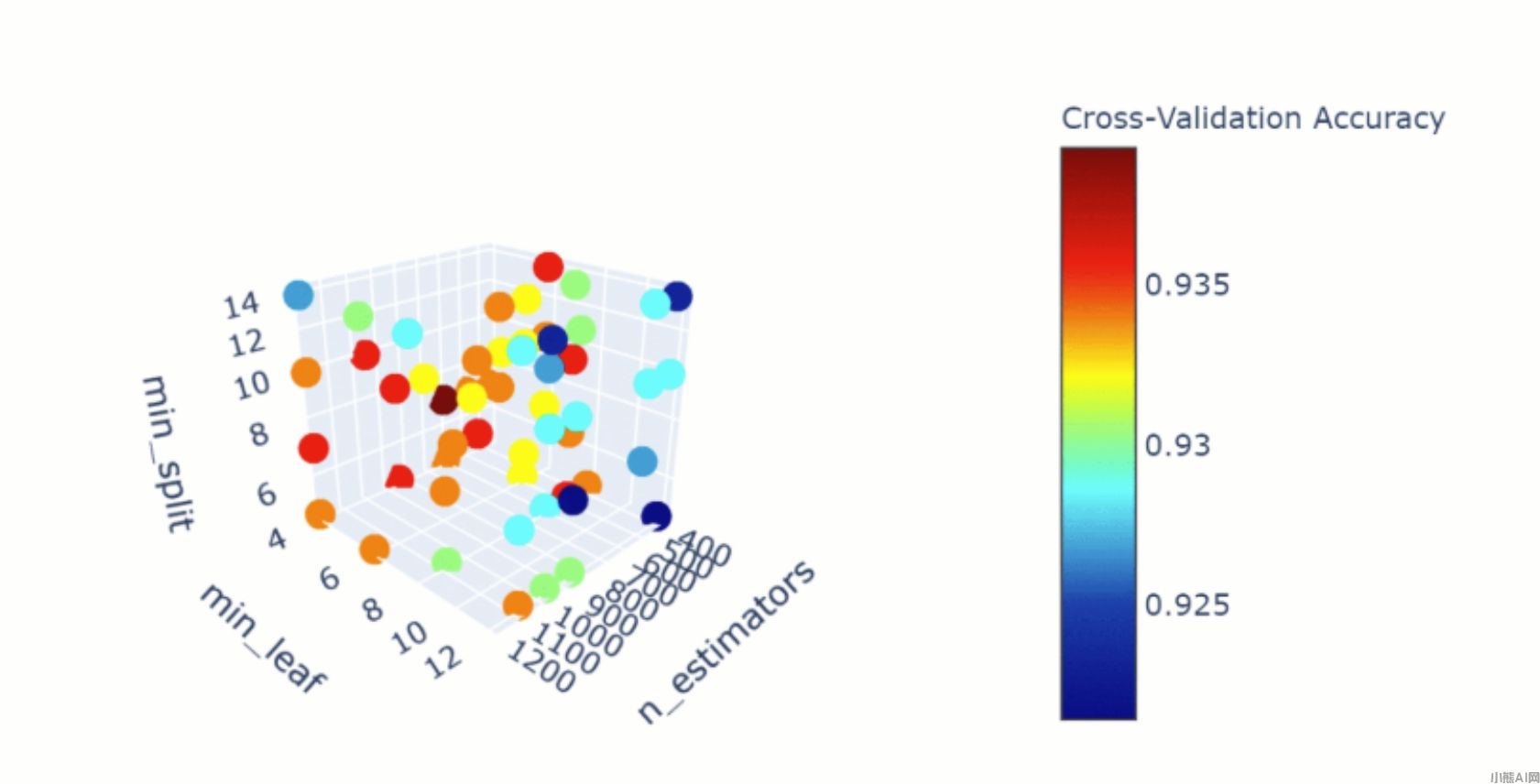

总之,超参数对AI大模型的训练过程和表现具有重要影响。选择合适的超参数需要进行实验和经验积累,并考虑不同的因素和场景。在实际应用中,可以通过网格搜索、随机搜索或贝叶斯优化等方法来寻找最优的超参数组合,以获得更好的模型性能和泛化能力。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1465.html