更逼真更自然!歌声驱动数字人口型的方案

导读:歌声驱动数字人口型是一种利用歌声或语音信号来控制数字人模型进行口型变化的技术。通过歌声或语音信号的输入,数字人模型能够根据声音的变化进行口型模拟,实现与人类歌手或发言者相似的口型动画效果。

1. 歌声驱动数字人口型方案

歌声驱动数字人口型有两种实现方案:

① 专业面捕方案:有专业设备、配套软件,优点是效果最佳,无限表情基。广泛应用于超写实虚拟人场景。

② 普通光学摄像头方案:通过普通手机摄像头可以实现,一般场景下效果完全可接受,标准 52 BS。适用于一般的虚拟人场景。

2. 口型驱动数据集构建

在口型驱动数据数据建设上,把全民K歌软件的用户 K 歌视频画面保留下来,同时录入用户唱歌干声数据。通过前面提到的单目动捕方案,把唱歌画面进行口型识别,拿到口型 BS 数据,再加上保留下来的用户唱歌干声数据,同时输入到歌声口型驱动模型。

歌声驱动数字人口型

歌唱驱动和说话驱动有差别:说话时嘴巴动的频率比较快,但是唱歌时因为要一口气唱下去,嘴巴表现更有连贯性;同时说话时嘴巴动的幅度没有歌唱时幅度大,这也是专门做歌唱口型驱动模型的原因。

3. TME 口型驱动模型

TME 口型驱动模型的方案同时用到两部分数据:一个是用户输入的干声数据,一个是歌词文件(歌词文件经过前处理,对歌词文件和音频做对齐,拿到每一个字精准的时间戳)。对输入音频和歌词做 Encoder 处理后,进行融合。把融合结果输入到另一个面部匹配预测模块,该模块会将当前帧的歌词、音频信息同之前全部帧的信息放在一起,做一个 Decoder 处理。最终预测到整首歌匹配变化后再转换为所需要的模型参数。

4. 实时性解决方案

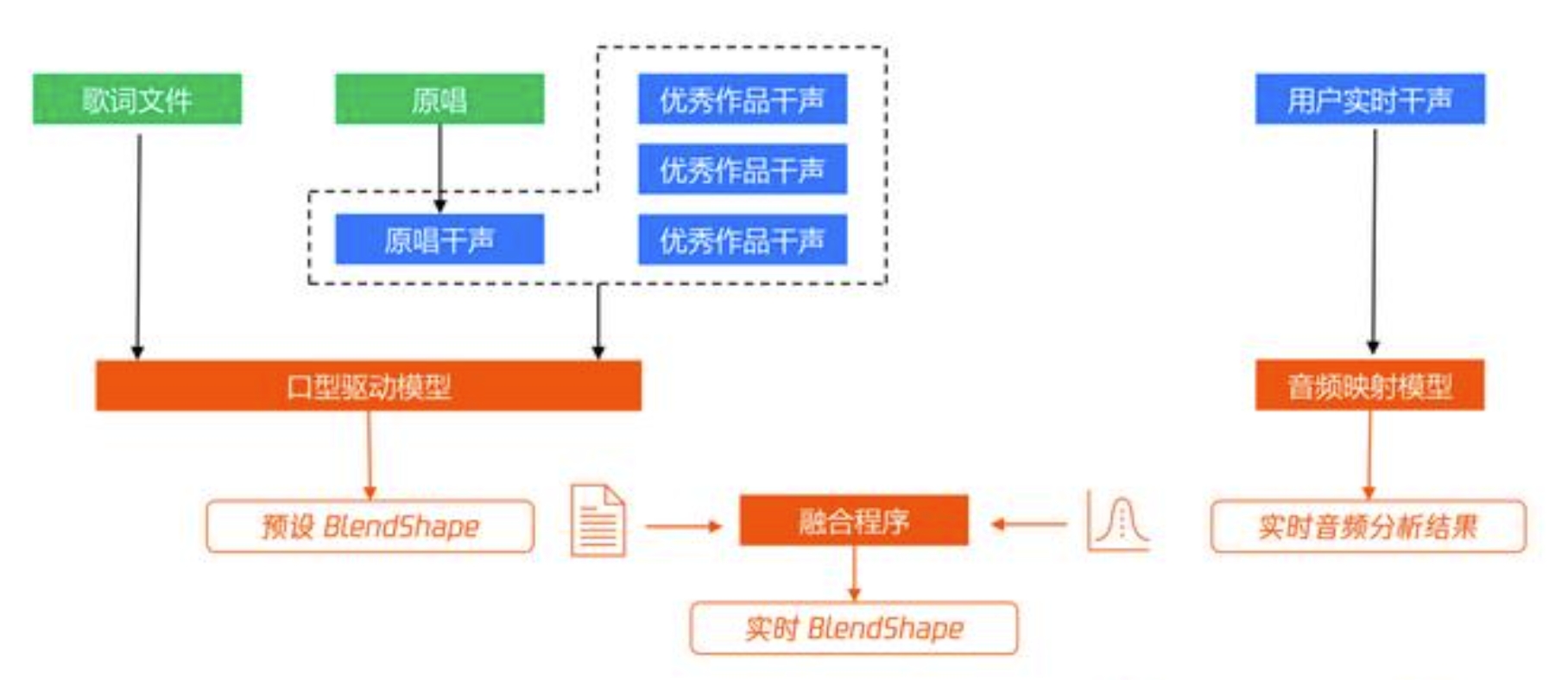

前面是异步生成视频的场景,实时性如何解决有如下考虑:先离线生成预设 BlendShape,输入测试文件及干声数据,干声来源于两个部分:一是之前用户唱的优秀作品干生;二是歌曲原唱,通过技术提取原唱的干声,然后把各式文件和综合干声,通过前面的口型驱动模型,得到预设 BlendShape。等到真正实施时,用户实时干声经过音频映射模型,得到实时音频分析结果,和前面的预设 BlendShape 进行融合,最后得到实时 BlendShape。这样就解决了实时性问题,同时兼备口型生成的效果。

实时性解决方案的相关技术已经上线应用,在全民K歌 8.0 的 QQ 秀可以体验到:一个场景是用户入唱时,会有 K 歌秀界面,一边唱一边可以看到 QQ 秀虚拟人的动作、口型等;另一个是在歌房场景也有类似体验。

这种技术可以帮助数字人模型更加生动地表现情感和表达思想,为虚拟偶像、虚拟歌手、语音助手等领域带来更丰富的表现力和交互体验。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/965.html