AI扫盲:Transformer模型是什么?

Transformer模型是由谷歌团队开发的一种自然语言处理(NLP)模型,它创新地采用了自注意力机制模块,与传统的RNN和CNN结构相比,具有更好的并行性,能够广泛地应用到各种任务中。

Transformer模型的核心是编码器和解码器两个部分,每个部分都包含6个block。

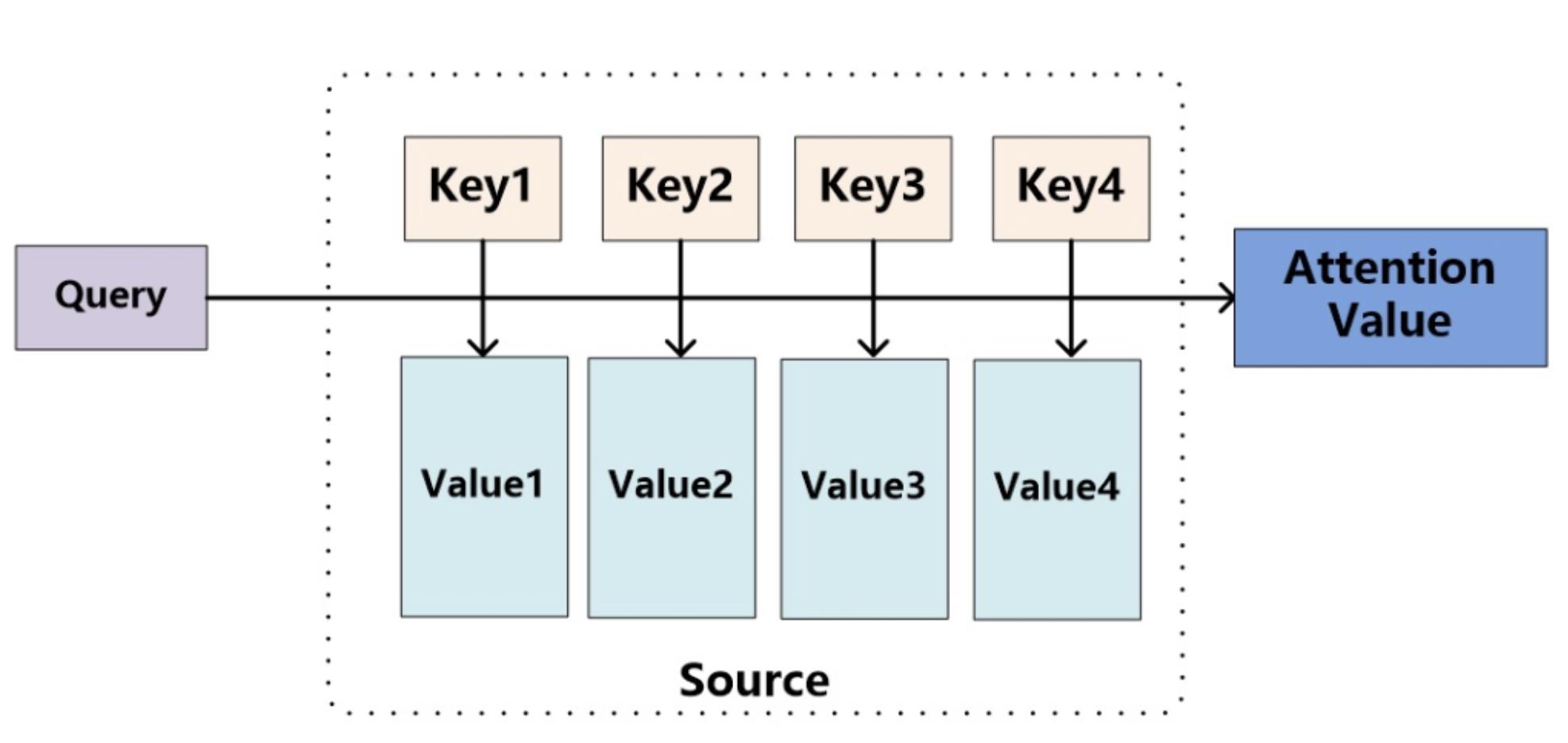

1、编码。在编码器中,输入句子经过词嵌入和位置编码后,通过多层自注意力机制和残差连接得到隐藏层,再通过线性层得到输出。

2、解码。在解码器中,将编码器的输出和目标序列作为输入,通过多层自注意力机制和残差连接得到隐藏层,再进行线性层得到输出。

以机器翻译为例,比如输入中文“我爱读书”,通过编码器处理后,得到隐藏层表示为:“我 i 爱 love 读书 read”,然后解码器将这个隐藏层表示翻译成英文“I love reading”,每个单词的翻译都是依据这个隐藏层表示进行的。

Transformer模型的优点

1、更好的并行性能:Transformer模型能够在所有位置同时计算,从而充分利用GPU并行计算的优势,加速了模型的训练和推理过程。能

2、够处理长序列:传统的循环神经网络模型在处理长序列时容易出现梯度消失和梯度爆炸的问题,而Transformer模型使用了自注意力机制,能够同时考虑所有位置的信息,从而更好地处理长序列。

3、更好的性能表现:Transformer模型在自然语言处理领域中已经取得了很多重要的研究成果,比如在机器翻译、文本生成、语言模型等任务中都取得了很好的效果。

Transformer模型的缺点

1、对于小数据集,Transformer模型的表现可能会不如传统的循环神经网络模型,因为它需要更大的数据集来训练。

2、Transformer模型的计算复杂度较高,需要更多的计算资源,比如GPU等。

3、Transformer模型的可解释性不如传统的循环神经网络模型,因为它使用了自注意力机制,难以解释每个位置的重要性。

随着时间的推移,Transformer模型被应用于各种不同的领域,比如自然语言处理、语音识别、计算机视觉、强化学习。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/742.html