梯度下降优化算法的意思是什么?

梯度下降优化算法是一种常用的机器学习算法,主要用于求解目标函数的最小值。在机器学习中,我们通常需要找到一个最优的模型参数,使得模型在训练数据上的表现最好。为了实现这个目标,我们需要定义一个目标函数(也称为损失函数或代价函数),用于衡量模型在给定参数下的预测性能。然后,通过调整模型参数,使得目标函数的值最小化。梯度下降算法就是这样一种用于寻找目标函数最小值的方法。

梯度下降算法的基本思想

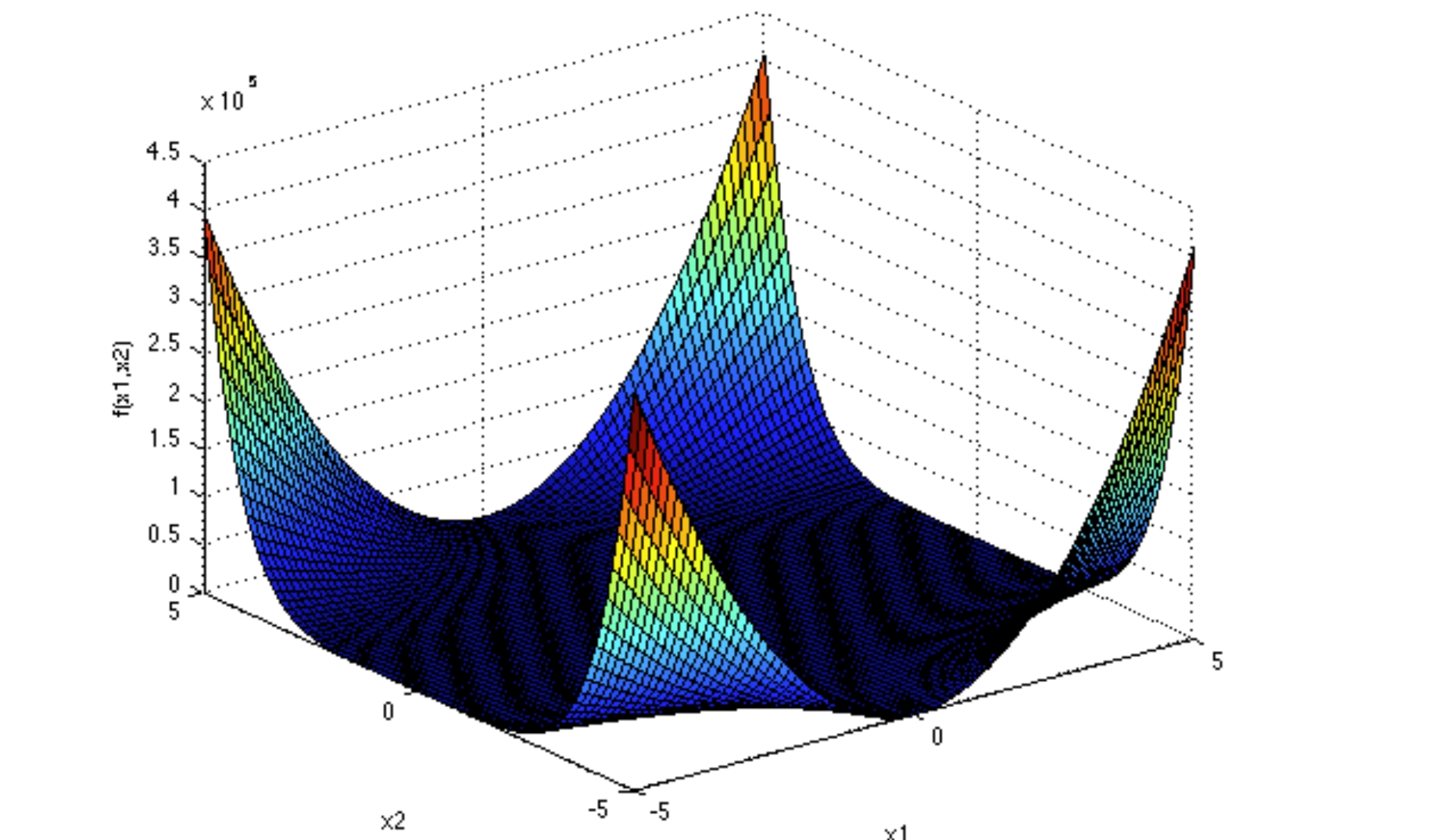

在每一次迭代过程中,沿着目标函数梯度(即导数)的负方向更新模型参数,从而逐步降低目标函数的值。具体来说,假设我们有一个包含n个参数的模型,我们首先随机初始化这些参数。然后,对于每一个参数,我们计算其在当前位置的目标函数梯度,并按照一定比例更新参数值。这个过程会重复进行多次,直到目标函数的值收敛到一个稳定的最小值。

梯度下降算法的工作原理

下面通过一个简单的例子来说明梯度下降算法的工作原理。假设我们有一个线性回归模型,用于预测房价。我们的目标是找到一个最优的权重w和偏置b,使得模型在训练数据上的预测误差最小。我们可以定义一个均方误差作为目标函数:

J(w, b) = 1/m * Σ(y_i - (wx + b))^2

其中,m表示训练数据的数量,y_i表示第i个样本的真实房价,(wx + b)表示模型对第i个样本的预测房价。我们的目标是找到一组参数(w, b),使得J(w, b)最小。

为了使用梯度下降算法求解这个问题,我们首先随机初始化权重w和偏置b。然后,对于每一个训练样本,我们计算其预测误差,并更新权重w和偏置b。具体来说,我们可以计算目标函数关于权重w和偏置b的梯度:

∇J/∂w = 2/m * Σ(-y_i * x_i + w * x_i + b - y_i)

∇J/∂b = 2/m * Σ(-y_i * x_i + w * x_i + b - y_i)

其中,x_i表示第i个样本的特征(房屋面积)。接下来,我们按照一定的学习率α更新权重w和偏置b:

w = w - α * ∇J/∂w

b = b - α * ∇J/∂b

这个过程会重复进行多次,直到目标函数的值收敛到一个稳定的最小值。通过这种方式,梯度下降算法可以帮助我们在复杂的模型空间中找到最优的参数组合,从而提高模型的预测性能。

梯度下降优化算法是机器学习和深度学习中非常重要的一个工具。它可以帮助我们找到一个函数的最小值点,从而优化模型的性能。在各种不同的应用场景中,梯度下降优化算法都发挥着重要的作用。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1904.html