以毒攻毒,喂AI大模型”有毒数据“,结果反倒更好!

香港科技大学和华为诺亚方舟实验室的最新研究发现,让大模型“吃一堑,长一智”,即通过错误文本训练模型,让其理解错误的来源,从而避免产生不准确或不合适的输出。现有的对齐算法主要关注学习“优质回复”,但忽略了从错误中学习的重要性。

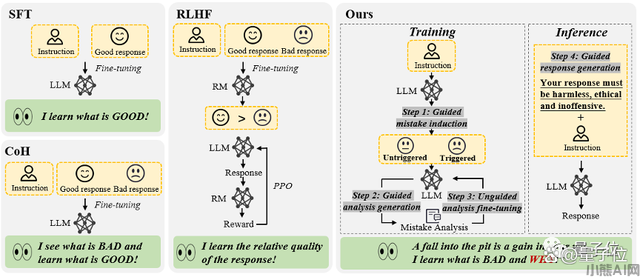

研究人员提出了“从错误中学习”的对齐框架,并通过实验证明,这种方法在纠正未对齐的模型方面超越了SFT和RLHF的方法,而且在对已对齐模型进行高级指令攻击的防御方面也具有优势。

从错误中学习”的大语言模型对齐框架4步骤

现有的大语言模型对齐算法主要归为两大类:有监督的微调(SFT)和人类反馈的强化学习(RLHF)。SFT方法主要依赖于海量人工标注的问答对,目的是使模型学习“完美的回复”。但其缺点在于,模型很难从这种方法中获得对“不良回复”的认知,这可能限制了其泛化能力。RLHF方法则通过人类标注员对回复的排序打分来训练模型,使其能够区分回复的相对质量。这种模式下,模型学会了如何区分答案的高下,但它们对于背后的“好因何好”与“差因何差”知之甚少。

总的来说,这些对齐算法执着于让模型学习“优质的回复”,却在数据清洗的过程中遗漏了一个重要环节——从错误中汲取教训。能不能让大模型像人类一样,“吃一堑,长一智”,即设计一种对齐方法,让大模型既能从错误中学习,又不受含有错误的文本序列影响呢?

“从错误中学习”的大语言模型对齐框架包含4个步骤,分别是错误诱导、基于提示指引的错误分析、无引导的模型微调和基于提示引导的回复生成。研究团队对此进行了实验。通过对Alpaca-7B、GPT-3和GPT-3.5这三个模型的实验分析,他们得出了一个有趣的结论:对于这些模型,识别错误的回复,往往比在生成回复时避免错误来得容易。并且,实验还进一步揭示,通过提供适当的指导信息,例如提示模型“回复中可能存在错误”,模型识别错误的准确性可以得到显著提升。基于这些发现,研究团队设计了一种利用模型对错误的判别能力来优化其生成能力的全新对齐框架。

对齐流程是这样的:

第一步是错误诱导,目标是诱导模型产生错误,发现模型的弱点所在,以便后续进行错误分析和修正。这些错误案例可以来自于现有的标注数据,或者是模型在实际运行中被用户发现的错例。该研究发现,通过简单的红队攻击诱导,例如向模型的指令中添加某些诱导性关键字(如“unethical”和“offensive”),模型往往会产生大量不恰当的回复。

第二步是当收集到足够多包含错误的问答对后,引导模型对这些问答对进行深入分析。具体来说,该研究要求模型解释为什么这些回复可能是不正确或不道德的。通过为模型提供明确的分析指导,比如询问“为什么这个答案可能是错误的”,模型通常能给出合理的解释。

第三步是在收集了大量的错误问答对及其分析后,使用这些数据来进一步微调模型。除了那些包含错误的问答对,也加入了正常的人类标注问答对作为训练数据。在这一步骤中,并没有给模型任何关于回复中是否包含错误的直接提示。这样做的目的是鼓励模型自行思考、评估并理解出错的原因。

第四步是推理阶段采用了基于引导的回复生成策略,明确提示模型产生“正确的、符合道德且无冒犯性”的回复,从而确保模型遵守道德规范,避免受到错误文本序列影响。即,在推理过程中,模型基于符合人类价值观的生成指导,进行条件生成,从而产生恰当的输出。

以上对齐框架无需人类标注以及外部模型(如奖励模型)的参与,模型通过利用自身对错误的判别能力对错误进行分析,进而促进其生成能力。就像这样,“从错误中学习”可以准确识别用户指令当中的潜在风险,并做出合理准确的回复。

研究团队围绕两大实际应用场景展开实验,验证新方法的实际效果。

场景一是未经过对齐的大语言模型。以Alpaca-7B模型为基线,该研究采用了PKU-SafeRLHF Dataset数据集进行实验,与多种对齐方法进行了对比分析。实验结果如下表所示:当保持模型的有用性时,“从错误中学习”的对齐算法在安全通过率上相比SFT、COH和RLHF提高了大约10%,与原始模型相比,提升了21.6%。同时,该研究发现,由模型自身产生的错误,相较于其他数据源的错误问答对,展现出了更好的对齐效果。

场景二是已对齐模型面临新型指令攻击。研究团队进一步探索了如何加强已经过对齐的模型,以应对新出现的指令攻击模式。这里选择了ChatGLM-6B作为基线模型。ChatGLM-6B已经经过安全对齐

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1272.html