知识蒸馏技术是什么?

模型压缩技术,是一种通过减少神经网络中的参数数量和计算量,来降低模型复杂度的方法。在深度学习中,模型的参数数量通常非常庞大,这会导致模型的训练和推理过程需要消耗大量的计算资源和存储空间。因此,模型压缩技术被广泛应用于提高模型的效率和可部署性。

知识蒸馏技术是什么

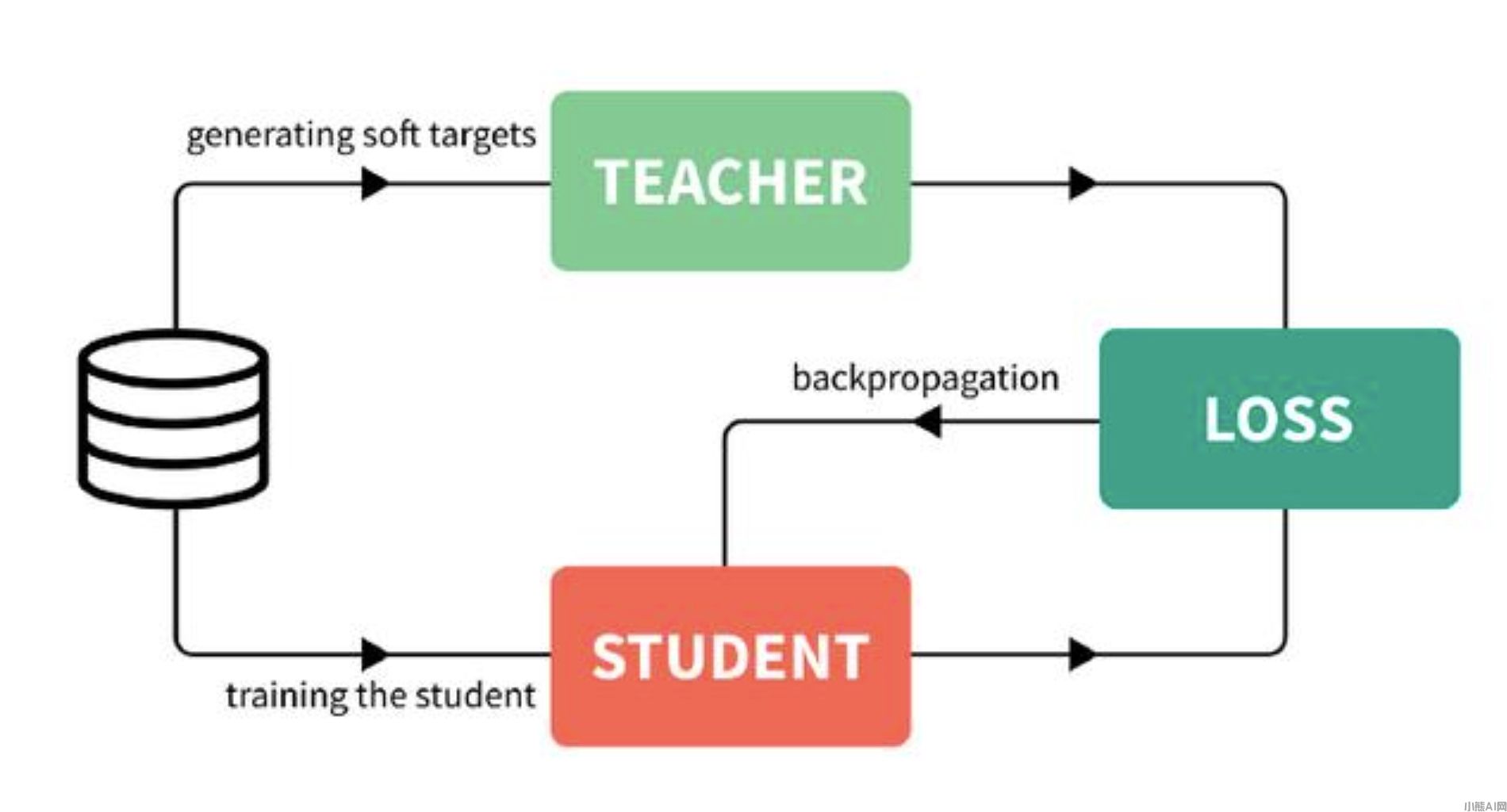

而知识蒸馏则是一种主要的模型压缩技术,它通过将一个大型的、复杂的神经网络(称为教师网络)的知识迁移到一个小型的、简化的神经网络(称为学生网络)中,从而减少模型的大小和计算量,同时保持较高的性能。

知识蒸馏模型

在知识蒸馏中,教师网络首先被训练好,然后将其输出作为软标签,传递给学生网络进行训练。软标签是指教师网络对每个输入样本的预测概率分布,而不是硬标签(即正确的标签)。学生网络的目标,是尽可能地学习到教师网络的知识,并在保持较高准确性的同时减小模型的大小。

知识蒸馏可以通过多种方法实现,如最小化教师网络和学生网络之间的KL散度、最小化教师网络和学生网络之间的交叉熵等。其中,最小化KL散度是最常用的方法之一,它通过最小化教师网络和学生网络的概率分布之间的差异来提高学生网络的性能。

知识蒸馏的优点是可以显著减小模型的大小和计算量,从而提高模型的效率和可部署性。此外,知识蒸馏还可以提高模型的泛化能力,因为它可以消除一些过拟合的问题。

知识蒸馏也存在一些限制和挑战

首先,知识蒸馏需要大量的计算资源和时间,来训练教师网络和学生网络。其次,知识蒸馏的效果,受到教师网络和学生网络之间的相似性的影响。如果两个网络的结构或参数设置不同,那么知识蒸馏的效果可能会受到影响。另外,知识蒸馏可能会导致一些信息的丢失或损失,从而影响模型的性能。

为了克服这些限制和挑战,研究人员提出了许多改进的方法和技术。例如,一些研究专注于设计新的神经网络架构,以提高教师网络和学生网络之间的相似性和兼容性。还有一些研究专注于优化知识蒸馏的训练算法和策略,以提高模型的性能和效率。

基于以上分析,知识蒸馏是一种重要的模型压缩技术,它可以显著减小模型的大小和计算量,同时保持较高的性能。虽然知识蒸馏还存在一些限制和挑战,但是随着技术的不断发展和完善,更多更强大的知识蒸馏技术将出现。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1231.html