新AI技术RingAttention,能降低Transformer需求内存

UC伯克利的研究人员提出了一种名为RingAttention的新方法,以解决深度学习模型中内存需求的挑战。

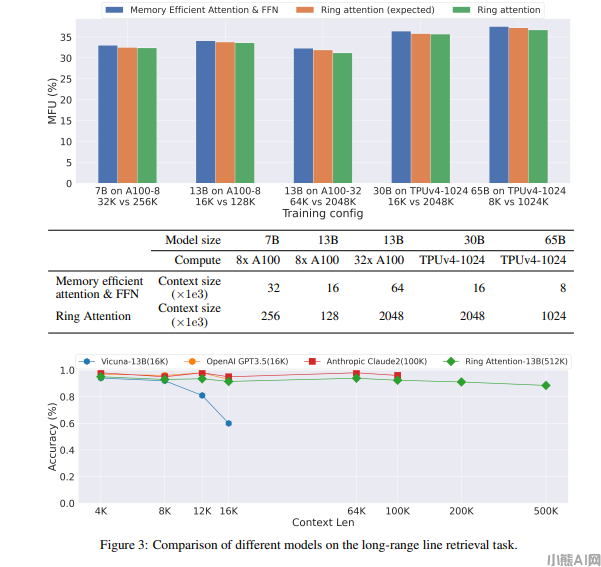

Transformer模型在处理长序列时面临内存需求问题,RingAttention方法通过将自注意力和前馈网络计算分块进行,实现内存高效。此方法将计算块分布在多个设备上,保持内存消耗与块大小成比例。

实验结果表明,RingAttention可降低Transformer模型的内存需求,使其能够训练比以前的内存高效方法长500倍以上的序列,而不需要对注意力机制进行近似。该方法为处理大规模数据提供了可能性。尽管研究仅涉及方法的有效性评估,但该方法的性能取决于设备数量,因此还需要进一步优化。

未来研究人员计划在最大序列长度和最大计算性能方面进行更多研究,这将为大型视频-音频-语言模型、利用扩展反馈和试验错误学习、代码生成和理解科学数据等领域提供激动人心的机会。

论文网址:https://arxiv.org/abs/2310.01889

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/1203.html