北大团队开源视觉语言大模型Video-LLaVA

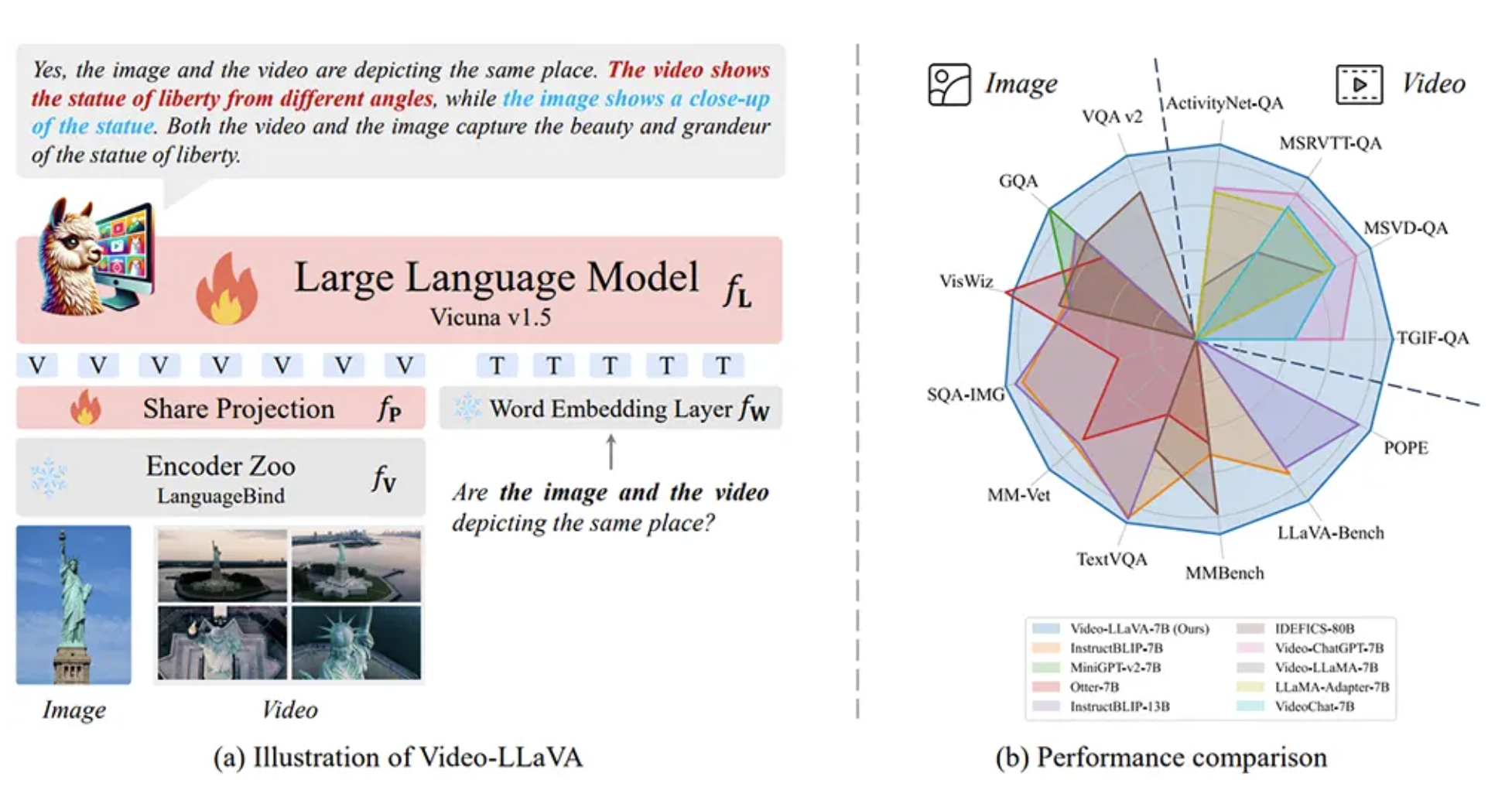

近日,北大等团队开源了视觉语言大模型Video-LLaVA。该模型将图像和视频表示对齐到统一的视觉特征空间,并在13个图片和视频基准上取得了先进的性能。值得一提的是,Video-LLaVA在训练过程中没有使用成对的视频和图片数据,但在训练后展现出了同时理解图片和视频的能力。

Video-LLaVA在多个图片、视频基准测试中超越了先前的SOTA(State-of-the-Art)方法。具体来说,它在MSVD、MSRVTT、TGIF和ActivityNet视频问答数据集上分别超出Video-ChatGPT成绩的5.8%、9.9%、18.6%和10.1%。这一成果表明,Video-LLaVA在处理视觉语言任务方面具有出色的能力。

该模型的开源将为研究人员和开发者提供一个强大的工具,用于进一步探索和应用视觉语言大模型。通过将图像和视频表示对齐到一个统一的视觉特征空间,Video-LLaVA能够更好地理解和处理与视觉相关的任务,如图像描述生成、视频问答等。

随着计算机视觉和自然语言处理领域的不断发展,视觉语言大模型的应用前景广阔。Video-LLaVA的开源将为相关研究提供重要的参考和借鉴,推动视觉语言大模型的发展和应用。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/info/1675.html