元象免费开源通用大模型“XVERSE-65B”

国内此前开源了多个70到130亿参数大模型,落地成果涌现,开源生态系统初步建立。然而,随着智能体(AI Agent)等任务复杂性与数据量的提升,业界与社区对更“大”模型的需求愈发迫切。

在国外开源生态中,Llama2-70B和Falcon-180B等标杆模型为“有条件”开源,设置了月活跃用户数或收入等商用上限,并因缺乏训练数据在中文能力上有明显短板。此外,美国新近颁布的AI芯片禁令,或将进一步限制中国大模型产业发展的速度。业界迫切呼吁一个高性能国产“大”模型,填补生态空白,为中文应用提供更强大的理解、推理和长文生成能力。

为推动国产大模型开源生态繁荣与产业应用快速发展,元象XVERSE公司宣布开源650亿参数高性能通用大模型XVERSE-65B,无条件免费商用,业界尚属首次。13B模型全面升级,提高“小”模型能力上限。这将让海量中小企业、研究者和AI开发者更早一步实现“大模型自由”,根据其算力、资源限制和具体任务需求,自由使用、修改或蒸馏元象大模型,推动研究与应用的突破创新。

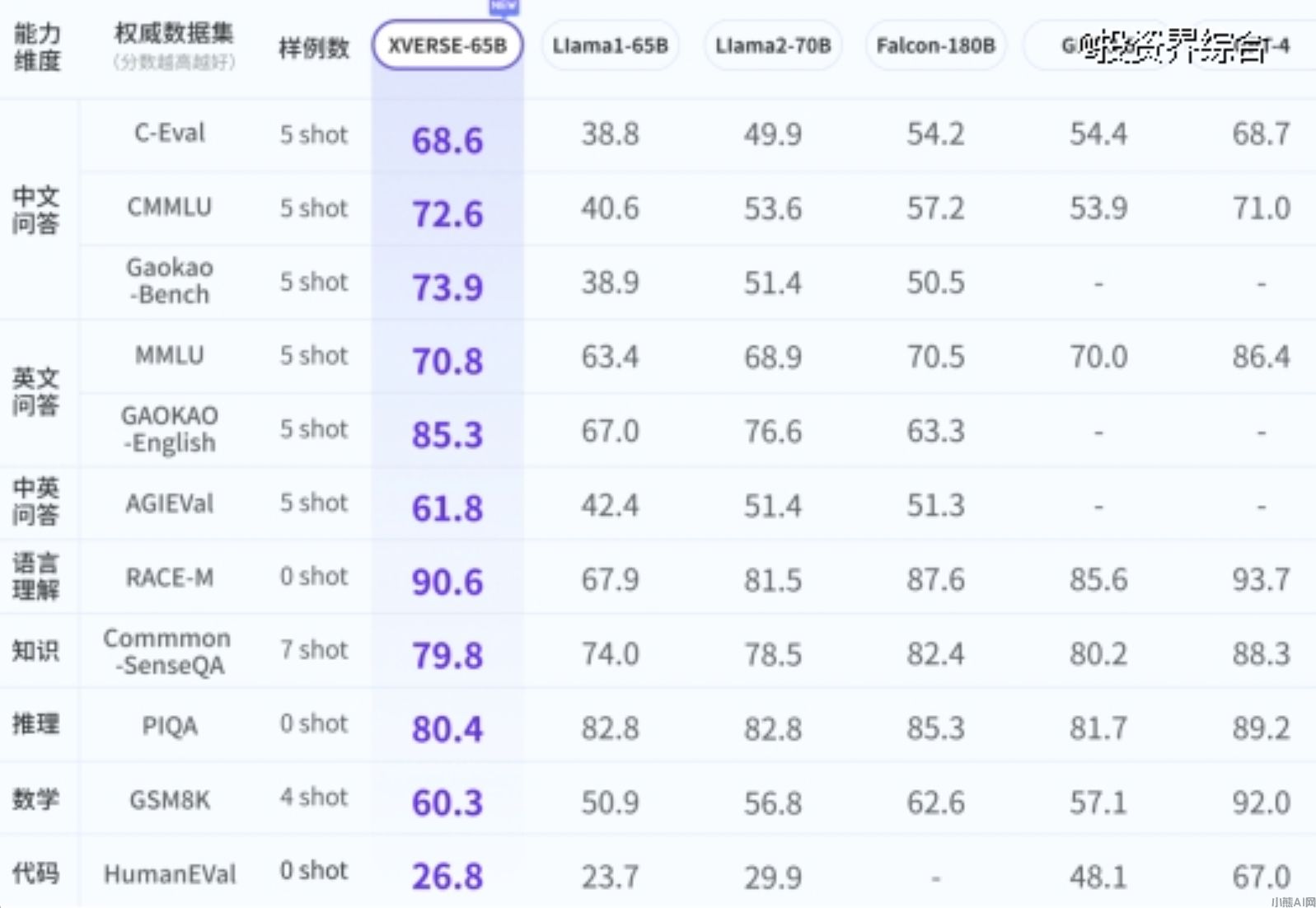

元象大模型评测

研究表明,参数量越高,高质量训练数据越多,大模型性能才能不断提升。而业界普遍共识是达到500到600亿参数门槛,大模型才能“智能涌现”,在多任务中展现强大性能。但训练此量级模型成本高昂,技术要求较高,目前主要为闭源付费提供。

元象XVERSE创始人姚星表示:“面对研发时间紧、算力持续短缺等挑战,团队依靠丰富经验,三个月内研发出多款高性能7B、13B模型,并最早为社区献上一个‘大有可为’的65B模型,为研究、商业及生态创造三重价值。”

具体而言,研发上,65B将为新技术、新工具、性能优化到模型安全提供“大杠杆”,让社区快速累积经验,也有助于推动国家科技自主可控的长远目标。商业上,海量中小企业能以零成本用上“大工具”,可突破局限,推动应用显著创新。元象也能深入了解用例、安全模型部署和潜在机会。在开发者生态上,社区能充分发挥组织协同优势,推动研发应用的“寒武纪大爆发”。

元象大模型系列均为全链条自研,涵盖多项关键技术与研发创新:复杂分布式系统设计、全面提升性能和提升训练稳定性。XVERSE-65B底座模型在2.6万亿Tokens的高质量数据上从头训练,上下文窗口扩展至16K,支持中、英、俄、法等40多种语言。XVERSE-65B Chat版也将在近期发布。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/aimodel/1400.html