机器学习之强化学习技术介绍

“强化”一词来自于心理学,心理学中的“强化”就是通过提供一种刺激手段来建立或者鼓励一种行为模式。

强化学习(Reinforcement Learning)则是一种机器学习技术,它基于反馈的学习方法,对算法执行的正确和不正确行为分别进行奖励和惩罚的制度,目的是使算法获得最大的累积奖励,从而学会在特定环境下做出最佳决策。

“强化”模式有两种:

积极强化,是指在预期行为呈现后,通过给予激励刺激以增加进一步导致积极反应。

负面强化,通过提供适当的刺激来减少出现负面(不希望的)反应的可能性,从而纠正不希望出现的行为。

想象一下,当你第一次玩马里奥,却没有人指导你怎么玩,你只能自己在游戏中探索环境和重要的NPC,并随时做好心理准备面对行动的后果。一个错误的举动会导致失去一条“命”,一个正确的跳跃可以把我们带到一个更安全的地方并奖励金币!因此,伴随着奖励和惩罚的探索,牵动着你的大量尝试和错误 ,最终不断地优化你的行动,让你成为一个马里奥游戏的高手。这就是“强化”训练!

这里有几个“强化”学习的要素需要明确:

代理人,Agent:一个我们试图学习的实体(即玩家在游戏中所使用的角色);

环境,Environment:代理人所处的环境(游戏所设置的游戏世界设定);

状态,State:代理人在环境中获得自己当前状态的各种信息;

行动,Actions:代理人在环境中所执行的与环境交互的各种动作(马里奥游戏中的行走、跑步、跳跃等等);

奖励,Reward:代理人从环境中获得的行动反馈(在马里奥的游戏里,即为正确的行动增加的积分/硬币,是一个积极的奖励。因落入陷阱或被怪物吃掉而丢失积分,或损失一条“命”,则是一个消极的奖励);

策略,Policy:根据代理人当前的状态决定一个合适的决策,以最大化地在未来某个时间段内获得正面报酬,最小化获得负面的惩罚;

价值函数, Value function:决定什么才是对代理人是有益的。

强化学习算法通常使用价值函数来评估状态或状态-动作对的价值。价值函数衡量了在某个状态下执行某个动作的长期累积奖励的期望。常见的强化学习算法包括Q-learning、SARSA、Deep Q-Network(DQN)和Policy Gradients等。

Q-learning是一种基于值函数的强化学习算法,它通过迭代更新Q值函数来逼近最优策略。Q值函数表示在给定状态下执行某个动作的长期累积奖励的期望。Q-learning算法通过贪婪地选择具有最大Q值的动作来更新策略。

SARSA是另一种基于值函数的强化学习算法,它与Q-learning类似,但在更新Q值函数时考虑了实际执行的动作和获得的奖励。SARSA算法通过在实际执行的动作上进行更新来逼近最优策略。

Deep Q-Network(DQN)是一种将深度学习与Q-learning相结合的强化学习算法。它使用神经网络来逼近Q值函数,并通过经验回放和目标网络等技术来提高稳定性和性能。DQN在Atari游戏等任务上取得了显著的成果。

Policy Gradients是一种基于策略的强化学习方法,它直接优化策略函数的参数以最大化期望的累积奖励。Policy Gradients通过梯度上升来更新策略函数的参数,从而逐步逼近最优策略。它在机器人控制、自然语言处理等领域有着广泛的应用。

除了以上几种常见的强化学习算法外,还有许多其他的强化学习技术和方法,如蒙特卡洛方法、时间差分方法、Actor-Critic架构等。这些技术和方法在解决不同类型的强化学习问题时具有各自的优点和适用场景。

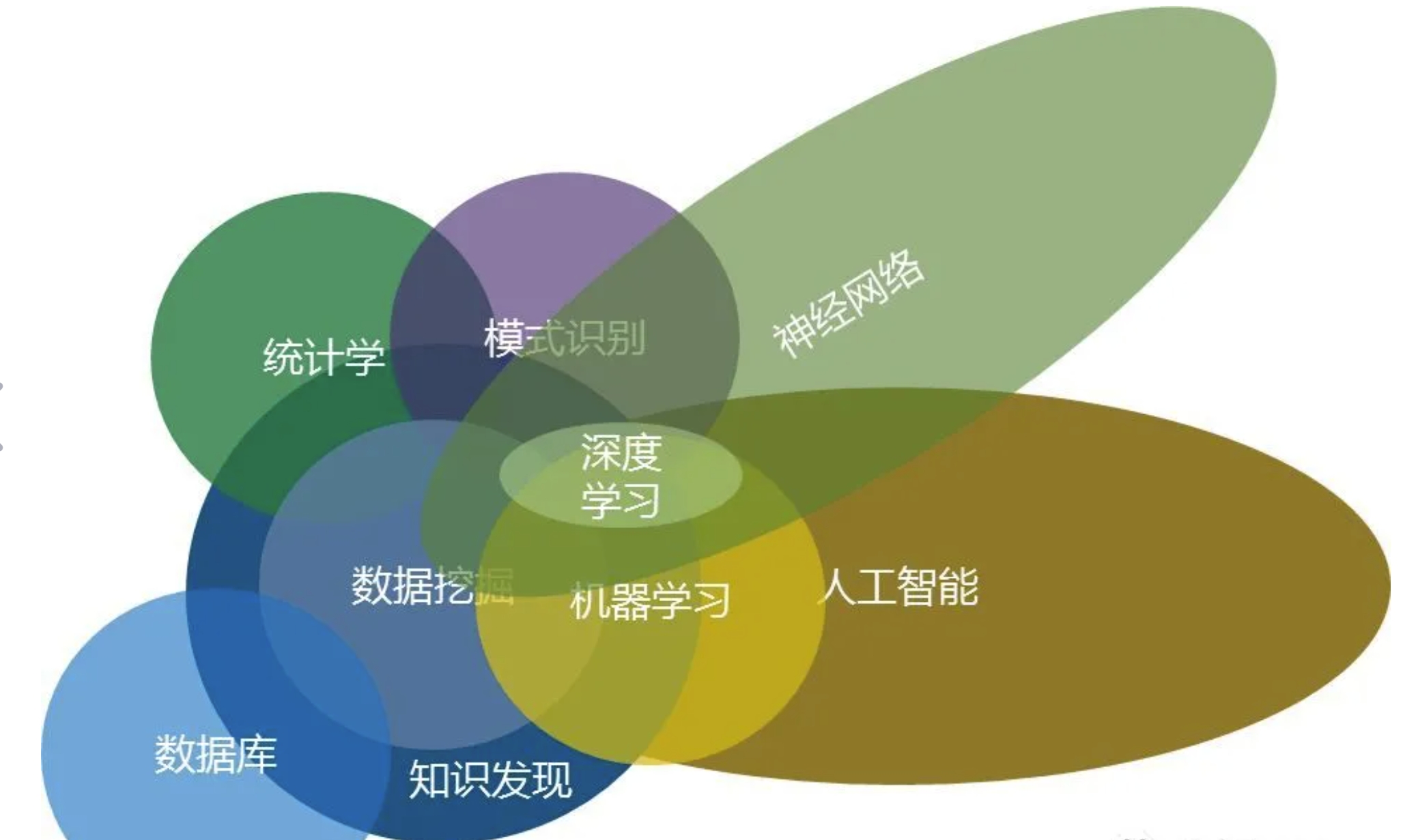

机器学习是多学科的交叉

因此,强化学习完全可以被理解为一种游戏方式的学习机制。让机器算法学习做任务,做得好就有奖励做得不好就有惩罚。当然,奖励和惩罚机制本身也是一种算法,这些算法被先天性地植入到机器学习算法的最底层设计中,让其最本能地目标首要考虑就是如何去赢得奖励且规避惩罚。然后,给机器算法一个最终的目标即可!

延伸阅读:

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/software/958.html