Stability AI推出音频AIGC工具Stable Audio

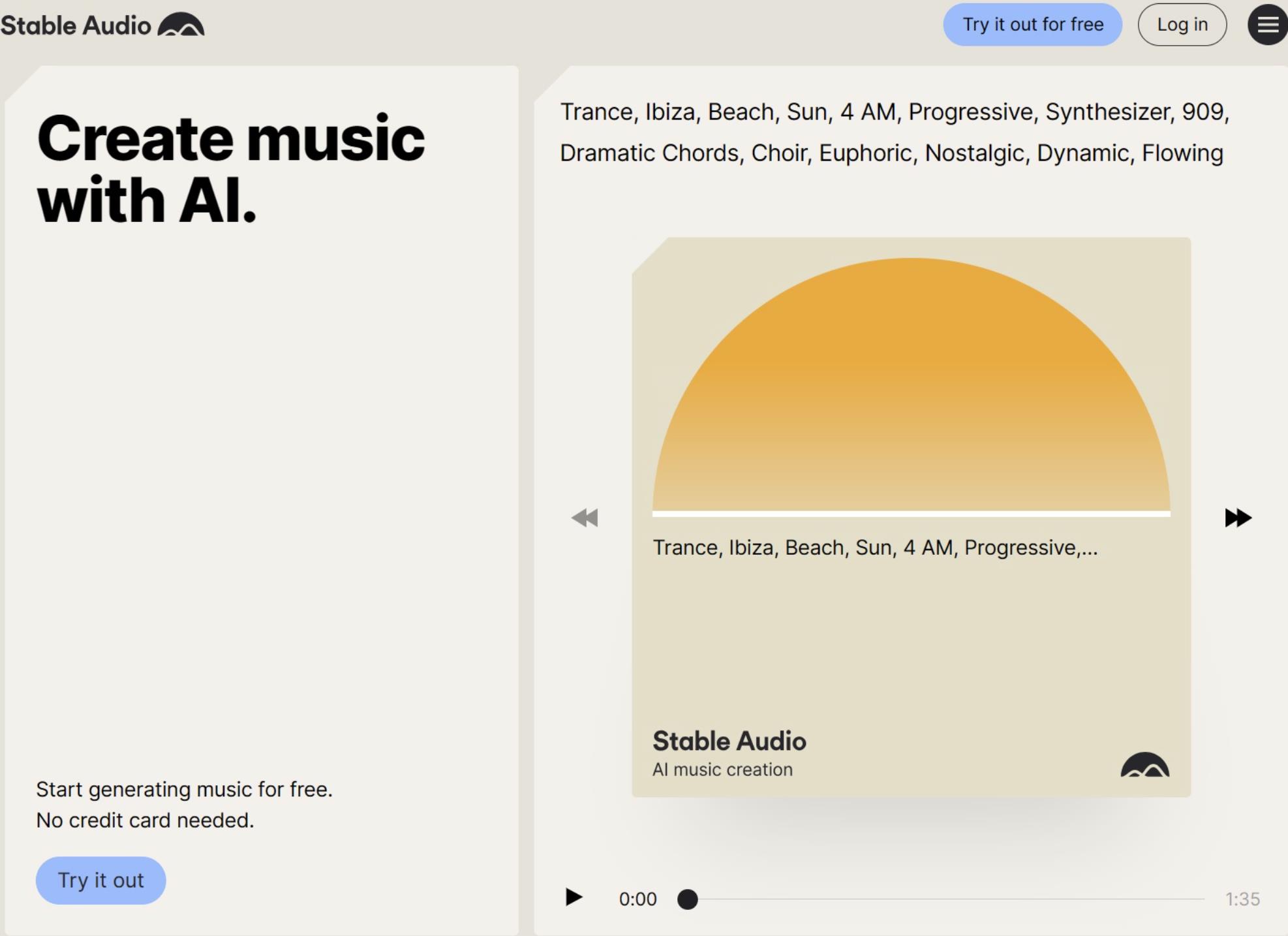

继推出文生图模型Stable Diffusion之后,Stability AI又推出了全新的产品——Stable Audio,正式进军音频生成领域。

Stable Audio是由Stability AI内部的声音实验室Harmonai研发的,采用了与Stable Diffusion类似的扩散模型技术。这次Stable Audio训练所采用的数据集授权,来自合作伙伴AudioSparx,包含了时长19500小时的80万条音频文件。

在AI音频生成产品领域,已经有多款类似的产品,例如谷歌的开源模型MusicLM、AIVA,以及基于机器学习的Mubert等。Meta也在今年8月开源了音频生成模型AudioCraft。这些产品都采用自然语言生成模式,用户可以输入一系列词语,对音乐的流派、速度、配器、情绪甚至应用场景进行指定。

从试听效果来看,Stable Audio相较于竞争对手有着较为显著的进步。它的声音品质得到了显著提升,很少出现AI生成音频中常见的嘈杂感和压缩感。然而,相对于人工创作的音乐,它在音乐的配器上仍然显得有些混乱。

Stability AI在官方页面中并未明确指出Stable Audio可生成的音乐流派。然而,从GameLook的试听感受上来看,该产品在EDM、氛围音乐、Disco等电子音乐上表现得更好,而在爵士、摇滚等注重器乐的音乐上则显得较为薄弱。

在商业模式上,Stability AI采取了与Midjourney类似的包月订阅模式。他们推出了免费和付费两个档位。免费档位允许用户每月生成20条音频,每条时长45秒,且不可用于商业用途。而付费档位的价格为每月11.99美元,允许用户每月生成500条最高90秒的音频文件,并可用于商业项目。

值得注意的是,Stability AI并未对Stable Audio模型进行开源,这与他们一直以来积极拥抱开源社区的作风有所不同。一些观察者猜测这可能与训练集的授权协议有关。然而,Stability AI承诺,Harmonai将在未来开源另一款使用不同数据训练的模型,这将基于Stable Audio的代码,允许用户自行训练音频模型。

此外,Stability AI还表示他们改进了音频训练的方式。传统的音频扩散模型往往在较长的音频文件中截取区块并进行训练,以适应扩散模型的训练时长。这种训练方法可能会导致生成的音乐缺失开头和结尾。而Stable Audio在训练时参照了音频的文字元数据,包括持续时长和开始时间,因此可以针对任意时间的音频进行生成。

随着Stability AI的加入,AI音频生成的赛道又多了一位有力的竞争者。随着游戏开发规格不断提升,厂商对游戏配乐的要求也在随之上涨。在游戏界推进AIGC应用的今天,AI音频生成或许也将成为一个重要的发展方向。

随着生成模型的不断迭代,未来AI生成的音乐内容将在品质和可用性上有着较大的提升,乃至于真正实现足不出户打造大师级配乐。从AI文生图产品的发展历程上来看,如果能够借助开源社区的广泛力量持续迭代,达成这样的效果并非天方夜谭。到时,游戏界也必然会拥抱AI音频产品。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/product/657.html