什么是门控循环单元(GRU)?

门控循环单元(Gated Recurrent Unit,简称GRU)是一种常用于循环神经网络(Recurrent Neural Network,简称RNN)的结构。与传统的RNN相比,GRU具有更简单的结构、更少的参数和更快的训练速度。它通过引入“门”机制来控制信息的流动,从而有效地捕捉长序列中的依赖关系。

在传统的RNN中,每个时间步都会将上一个时间步的隐藏状态作为输入,并通过更新函数来生成当前时间步的隐藏状态。然而,这种简单的更新方式存在一些问题。首先,由于梯度消失或梯度爆炸的问题,传统的RNN很难学习到长距离的依赖关系。其次,由于每个时间步都需要保存上一个时间步的状态,传统的RNN在处理长序列时会占用大量的内存和计算资源。

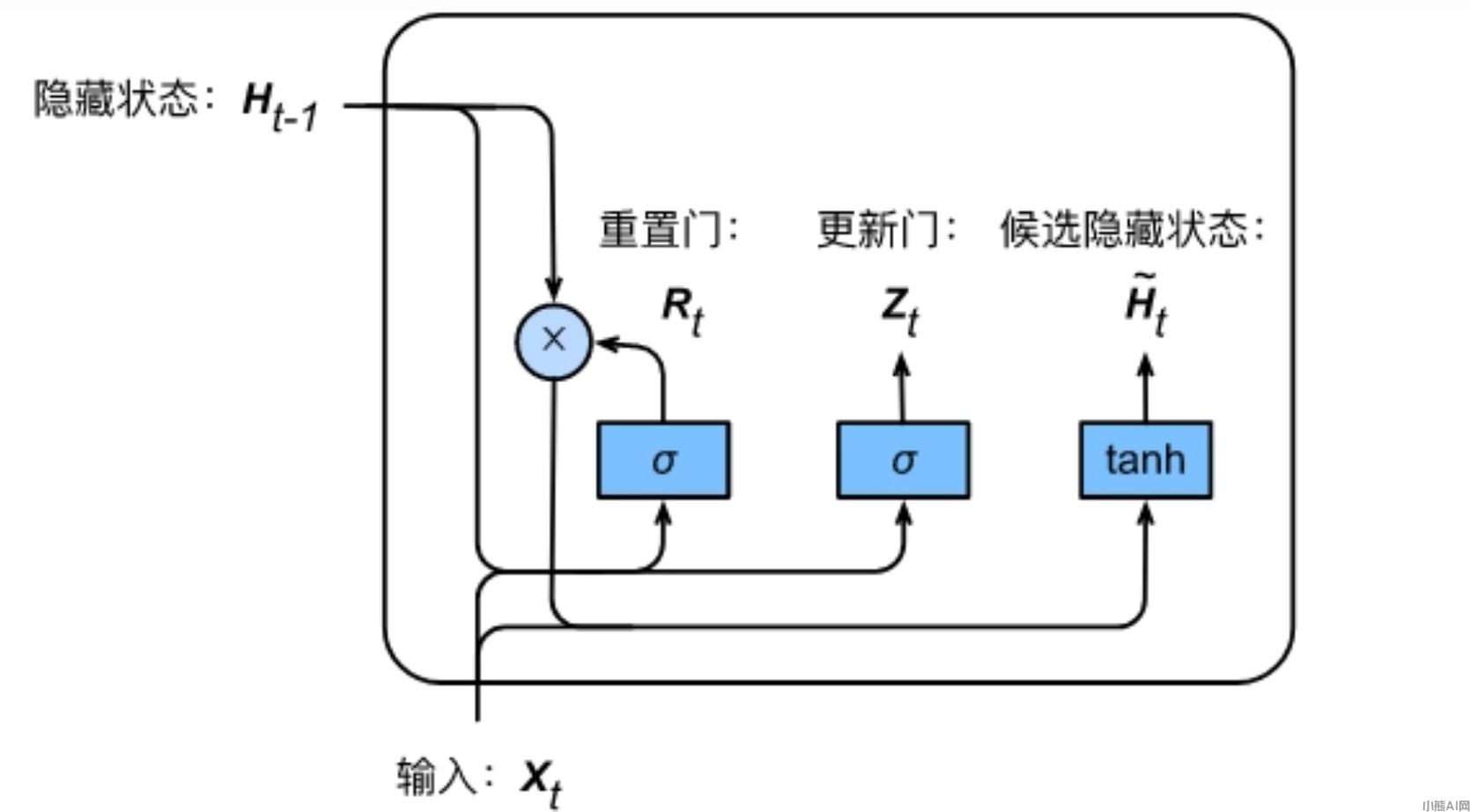

为了解决这些问题,GRU引入了两个“门”机制:重置门(Reset Gate)和更新门(Update Gate)。

门控循环单元(GRU)

重置门用于决定是否将上一个时间步的状态信息保留下来,更新门用于决定如何根据当前时间步的输入和上一个时间步的状态来更新隐藏状态。这两个门都是通过sigmoid激活函数来实现的,它们的输出范围在0到1之间。

具体来说,重置门的输出决定了上一个时间步的状态信息的保留程度。当重置门的输出接近于0时,表示上一个时间步的状态信息对当前时间步的影响较小,可以将其忽略;当重置门的输出接近于1时,表示上一个时间步的状态信息对当前时间步的影响较大,需要将其保留。更新门的输出则决定了当前时间步的隐藏状态如何根据输入和上一个时间步的状态来更新。当更新门的输出接近于0时,表示当前时间步的输入对隐藏状态的影响较小,可以忽略;当更新门的输出接近于1时,表示当前时间步的输入对隐藏状态的影响较大,需要将其考虑进来。

通过这种方式,GRU可以在每个时间步只保留一部分上一个时间步的状态信息,从而减少了参数的数量和计算量。同时,由于重置门和更新门的存在,GRU可以更好地捕捉长序列中的依赖关系,避免了梯度消失或梯度爆炸的问题。这使得GRU在许多自然语言处理和语音识别任务中取得了很好的效果。

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/QA/1380.html