什么是端侧大模型推理?

端侧大模型推理,是指将大型机器学习模型部署到终端设备上进行推理的过程。传统的机器学习模型通常需要在云端进行处理和计算,但这种方式存在一些限制,如网络延迟、数据隐私等问题。而端侧大模型推理则可以将模型直接部署到终端设备上,实现实时的推理和决策。

端侧大模型推理的优势主要体现在以下几个方面:

1. 实时性:由于模型部署在终端设备上,可以实时获取数据并进行推理,无需等待数据传输到云端进行处理,提高了系统的响应速度。

2. 低延迟:端侧推理可以减少数据传输的时间,降低网络延迟,提高系统的响应速度。这对于一些对实时性要求较高的应用场景非常重要,如自动驾驶、智能监控等。

3. 数据隐私保护:端侧推理可以在本地完成数据处理和推理,不需要将数据上传到云端,保护了用户的隐私数据安全。

4. 资源利用率高:端侧推理可以利用终端设备的计算资源进行模型推理,减少了对云端资源的依赖,提高了资源利用率。

然而,端侧大模型推理也面临一些挑战:

1. 计算资源限制:终端设备的计算资源有限,无法与云端相比。因此,需要对模型进行压缩和优化,以适应终端设备的计算能力。

2. 能耗问题:端侧推理需要消耗终端设备的能源,对于一些电池供电的设备来说,能耗是一个重要考虑因素。因此,需要设计高效的算法和模型,以降低能耗。

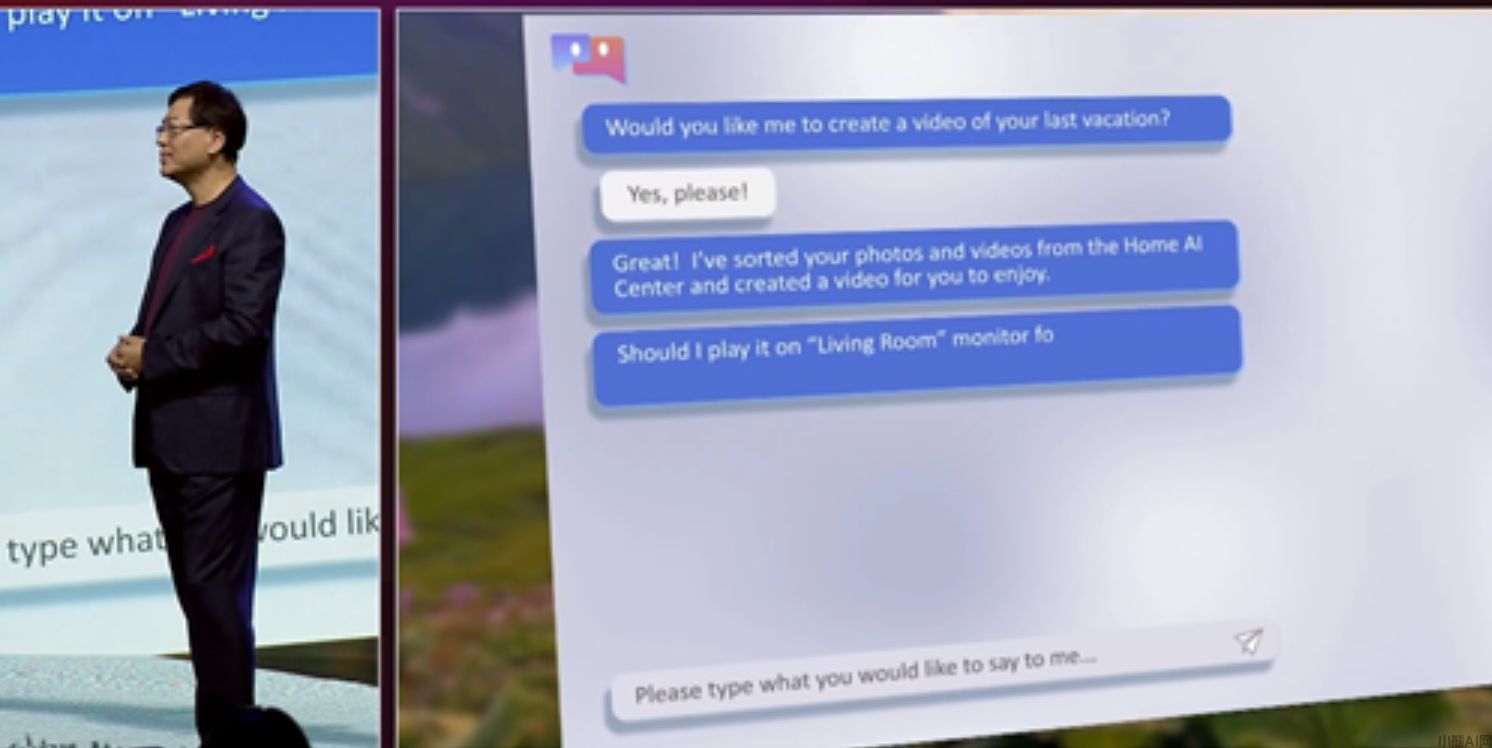

2023年10月24日晚,联想在北京举办了名为"2023联想Tech World"的创新科技大会。在这次大会上,联想CEO杨元庆向大家展示了联想智能设备AI PC和AI Moto的重点功能,即端侧运行大模型推理。这一创新技术将为用户带来更加便捷、高效的使用体验,同时也标志着联想在人工智能领域的技术实力再次得到了提升。

联想CEO杨元应展示有端侧大模型推理的AI PC

在PC端侧运行AIGC应用 Intel正打造开源框架BigDL-LLM

本文由小熊AI网发布,不代表小熊AI网立场,转载联系作者并注明出处:https://www.xiaoxiong360.com/html/QA/1263.html